数据科学算法ch1-算法评价标准

分类问题

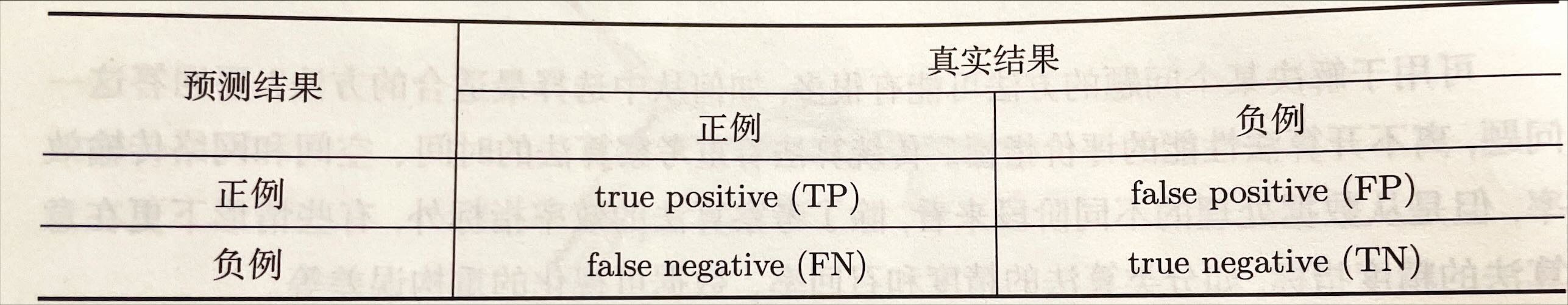

以二分类为例,真实的样本标签有两类,分类器预测的标签也有两类,真是标签和预测标签的不同组合构成了一个混淆矩阵。其中:

- 真阳性(true positive, TP): 正例样本被分类器预测为正例

- 假阳性(false positive, FP): 负例样本被分类器预测为正例

- 真阴性(true negative, TN): 负例样本被分类器预测为负例

- 假阴性(false negative,FN): 正例样本被分类器预测为负例

- 召回率:真阳性率(TPR), 反映模型的查全率,定义为:

可以这么理解,召回率是通过这个模型,有多少正例成功地被预测为正例,因为有一部分被预测称了负例。主要聚焦在正例样本上

- 准确率:反映模型的查准率,定义为:

准确率用来衡量模型的精度,因为模型可能会把一些负例预测为正例,导致精度缺失

- $F_\beta$ 值:召回率或者准确率知识衡量了分类器某一方面的性能,综合召回率和准确率而定义 $F_\beta$ 值为:

其中,$P$ 为准确率、 $R$为召回率。因此 $F_\beta$ 值是召回率把和准确率的加权调和平均数,通常取 $\beta$ 的值为1

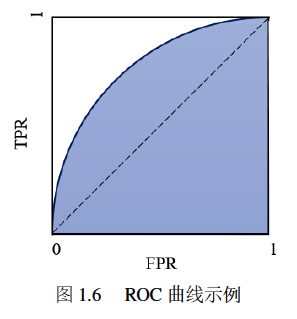

- ROC曲线下方的面积(AUC):ROC所在的坐标系,其横坐标为假阳性率(FPR), 纵坐标是真阳性率(召回率)

AUC值越大,代表ROC越靠近左上角,在相同假阳性率情形下,分类器可能具有更大的召回率,分类器表现更好。